Einleitung

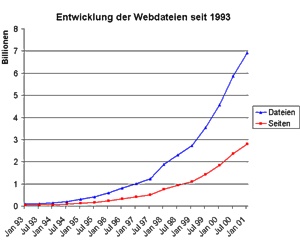

Während der letzten 6 Jahre hat sich aus dem Internet ein Medium entwickelt, mit dessen Hilfe man zu fast jedem Thema Informationen erhalten kann. Fast jede Information ist zudem kostenlos abrufbar, sieht man davon ab, daß sich viele Angebote durch Werbung finanzieren. Laut einer aktuellen Studie von Nielsen/Netratings zufolge gab es im März 2001 bereits über 211 Millionen Menschen, die das Internet benutzen. Demgegenüber steht eine Zahl von schätzungsweise über 1659 Billionen Adressen (ausgeschrieben: 1659000000000000 !) für Informationsseiten und Mediadateien im WWW. (Diese Zahl ergibt sich aus den von der Internet Software Consortium und der Netcraft Web Server Survey ermittelten Zahlen von Hosts, multipliziert mit der durchschnittlichen Zahl von 57.157 aufgerufenen URLs für alle virt. Webserver der Universität Erlangen-Nürnberg. Bei einer durchschnittlichen Größe von 48,317 kB machen diese Seiten einen Datenbestand von 74669 TeraByte aus! Einige Leute verdeutlichen sich Datenmengen gern in DinA4-Seiten. Ich hab mir mal die Mühe gemacht, es auszurechnen: Bei einer Größe von 2kB pro DinA4-Seite erhalten wir 3,98×1013 Seiten, die aufeinandergestapelt eine Höhe von ca. 1.991.240 km erreichen würden.

Diese riesige Datenmenge steht den Benutzern frei zur Verfügung – hat dieser einmal verstanden, wie er darauf zugreifen kann. Es gibt Informationen zu allen Themen, seien sie noch so abstrus oder zweifelhaft. Dabei ist diese Datenmenge noch nicht einmal alles. Das Internet besteht nicht nur aus dem WWW, sondern auch aus anderen Netzen und Systemen, über welche man ebenfalls Informationen erhalten kann. So sei hier nur das Usenet und das IRC genannt, welche sich als Medien zum Austausch mit anderen Personen auf der ganzen Welt anbieten.

Bei all diesen Informationen und all diesen Leuten, welche das Internet benutzen, bei all dem Hype und der Aufregung darum, stellt sich die Frage: Was macht es aus? Ist es wirklich nur ein bißchen Technik, eine bessere Telefonleitung mit etwas Software, oder aber ist es ein neuer Kulturraum, wie es Andy Müller-Maguhn, einer der amtierenden Präsidenten der ICANN es sieht?

In diesem Artikel möchte ich einen Ausblick darüber geben, was sich naher Zukunft an Entwicklungen ergeben kann. Diese Prognose steht natürlich nicht einfach im Raum und erfaßt die nächsten 100 Jahre, sondern erstreckt sich auf einem Zeitraum nicht länger als 6-9 Monate und beruht auf die aktuellen Arbeiten und Ankündigungen von IT-Dienstleister. Ich unterteile die derzeitigen Entwicklungen nach den Themen „Browser-Technologie“, „Webserver“, „Neue Internet-Techniken“ , „Internet-Dienstleiter“ und „Kulturraum Internet“.

1. Browser-Technologie – „Netscape ist tot, es lebe Mozilla“

War der Browser-Krieg zwischen Netscape und Microsoft noch vor einem halben Jahr für den MS Internet-Explorer entschieden, so hat sich diese Situation in den letzten Monat wieder geändert: Mit Mozilla ab der Version 0.9.2. ist ein neuer Browser auf dem Markt, welcher das Zeug dazu hat, den Internet-Explorer Markanteile abzujagen.

Um dies zu erreichen wird aber zuerst Netscape bluten müssen: Mit der 6er Version des Netscape Navigators beruht dieser auf einer komplett neuen Technik. Es wird hierbei der Quellcode des OpenSource-Browsers Mozilla verwendet. Der Unterschied zwischen Netscape und Mozilla besteht dabei darin, daß AOL diverse Tools hinzufügt, wie z.B. das Shopping-Symbol und den Messenger. Da jedoch der Ursprungscode immer vom Mozilla-Browser kommt, ist abzusehen, daß Benutzer früher oder später auf diesen Browser umsteigen anstelle zu warten, bis die neue Mozilla-Version in einen neuen Netscape migriert wurde.

Um dies zu erreichen wird aber zuerst Netscape bluten müssen: Mit der 6er Version des Netscape Navigators beruht dieser auf einer komplett neuen Technik. Es wird hierbei der Quellcode des OpenSource-Browsers Mozilla verwendet. Der Unterschied zwischen Netscape und Mozilla besteht dabei darin, daß AOL diverse Tools hinzufügt, wie z.B. das Shopping-Symbol und den Messenger. Da jedoch der Ursprungscode immer vom Mozilla-Browser kommt, ist abzusehen, daß Benutzer früher oder später auf diesen Browser umsteigen anstelle zu warten, bis die neue Mozilla-Version in einen neuen Netscape migriert wurde.

Im Unterschied zwischen Mozilla und IE überzeugt Mozilla dadurch, daß sich dieser konsequent an die Richtlinien des W3C’s hält und properitäre Erweiterungen für einzelne Browsern ignoriert. Dies sorgt zwar dafür, daß einige Seiten, die spezielle Befehle nutzen, welche nur für den IE entworfen wurden, nicht korrekt angezeigt werden, jedoch wird dieser Nachteil dadurch weggemacht, daß Mozilla wegen der strengen Einhaltung der HTML- und CSS-Definitionen für Webmaster zum verläßlicheren Partner geworden ist. Die Vorgaben des CSS2-Standards werden derzeit nur zufriedenstellend von Mozilla erfüllt, während der IE an dieser Stelle noch Probleme aufweist.

Zwar haben sich einige Designer und Agenturen darauf festgelegt, den IE als Standard anzusehen und nicht mehr auf andere Browser Rücksicht zu nehmen; Jedoch zeigen die Auftritte größerer Dienstleister, wie der von der Deutschen Bank, daß gutes Webdesign auch für unterschiedliche Browser und Betriebssysteme mögliche ist.

Wobei man gleich beim nächsten Punkt ist, der für einen kommenden Erfolg von Mozilla spricht: Im Gegensatz zu dem IE, ist Mozilla auf einer Vielzahl von Betriebsystemen erhältlich. Dies ist deswegen von Bedeutung, da der Linux-Anteil sowohl im Homebereich, als auch im beruflichen Bereich steigend ist. Da die IE-Portierung auf Linux- und UNIX-Plattformen jedoch sehr fehlerhaft ist und erst lange nach der Veröffentlichung der Windows-Version erfolgt, hat der IE auf diesem Bereich auf absehbarer Zeit wenig Marktchancen.

Für Systemadministratoren, die für ein heterogenes Netz, wie das an der Universität, zuständig sind, ist die Frage nach dem Standard-Browser nicht lang zu entscheiden: Es wird der Browser verwendet, welcher auf möglichst vielen Betriebssystemen verwendet werden kann, spart dies doch Kosten in der Schulung und der Beratung.

Ein weiterer Pluspunkt von Mozilla ist der mitgelieferte Mail-Client. Als einer der wenigen Mail-Clients erlaubt dieser das gleichzeitige nutzen und verwalten mehrerer IMAP- und POP-Mailaccounts. Zudem überzeugt er durch diverse Sicherheitsmechanismen. Die Konkurrenz durch den Mail-Client Outlook Express von Microsoft besteht dabei nur darin, daß Outlook unter Windows bereits vorinstalliert ist und deswegen häufig verwendet wird. Die vielen Vorkommnisse in Bezug auf Viren- und Hackerattacken, die nur und explizit Outlook als Sicherheitsloch ausnutzen, wird dagegen noch einige Zeit im Gedächtnis der erfahrenen Benutzer haften bleiben.

2. Webserver – Apache bleibt Marktführer

Unbestrittener Platzhirsch bei der Webserver-Software ist nach wie vor Apache. Dies wird sich auf absehbarer Zeit auch nicht ändern. Mit einem Anteil von über 60% weltweit und einer steigenden Akzeptanz von OpenSource-Produkten in der Wirtschaft bleibt dies auch eine Weile. Zwar hat der Webserver von Microsoft im Juli 2001 stark in der Verbreitung zugelegt, jedoch kam bekam er durch die Attacken durch den Worm „Code Red“ auch für die breitere Öffentlichkeit den Ruf eines unsicheren Produktes. Die Konsequenzen hieraus bleiben abzuwarten;

Negativ auf den Microsoft Webserver werden sich, zumindest in Deutschland, auch Tendenzen in der Politik auswirken, die eine Förderung von OpenSource-Produkten und den Einsatz in Behördeneinrichtungen verlangen.

Negativ auf den Microsoft Webserver werden sich, zumindest in Deutschland, auch Tendenzen in der Politik auswirken, die eine Förderung von OpenSource-Produkten und den Einsatz in Behördeneinrichtungen verlangen.

Wie auch bei den Webbrowsern wirkt sich als Dritter Punkt das Thema OS-Kompatibilität aus: Die steigende Verbreitung von Linux als Serverplattform hat zur Folge, daß immer mehr Firmen eine heterogene Betriebssystem-Landschaft haben. Eine Software, die auf mehreren Systemen zum Einsatz kommen kann, wird auf lange Sicht immer den Vorzug bekommen gegenüber Software, die nur auf einem System vorkommt.

3. Neue Internet-Techniken – Mehr Intelligenz und alte Schuhe im neuen Design

Seit Anfang 2000 hat sich, den vollmundigen Presseerklärungen von Unternehmen zum Trotz, nicht viel getan. Zwar gibt es einige neue Techniken, jedoch stellt sich nach einer genaueren Analyse heraus, daß diese meist nur auf vorhandenen aufbauen. So wurde die Abkürzung XML zwar zum unverzichtbaren Marketing-Schlagwort für fast jede Applikation die mit Datenbanken und Content-Management zu tun hat, jedoch beruht die Idee von XML (http://www.w3.org/XML) auf Ansätzen, die bereits in 70er Jahren aktuell waren; Trotzdem kam es zu einen wahren Run auf allem was irgendwie „XML“ als Label hatte: Selbst einzelne Datenbanken wurden in XML realisiert. Content-Management-Systeme mußten ihre Daten per XML austauschen können (selbst wenn dies niemals einer benötigte), und sogar Microsoft bot auf einmal XML-Schnittstellen an.

Die Euphorie ist jedoch inzwischen verklungen. Entwickler besinnen sich zurück auf etablierte Datenbankensysteme und erkennen immer mehr, daß XML nur als Schnittstellensprache, nicht jedoch als Datenbankensprache, ausgelegt ist. Eine andere Entwicklung im Internet liegt im Bereich des WWW in der Fortentwicklung von HTML und CSS („Cascading Stylesheets“). Immer mehr Webseiten steigen derzeit um von der reinen HTML-Nutzung zu HTML mit CSS. CSS bietet durch die Möglichkeit, auf die Interpretation von HTML-Tags Einfluß zu nehmen, bessere und standardisiertere Möglichkeiten bei der Gestaltung von Webseiten als „pures“ HTML es allein kann.

Die steigende Nutzung von CSS wiederum wirkt sich auf den Gebrauch der Browser aus, können doch nur Browser der neuen Generationslinien CSS darstellen. Die nächste Version von CSS können derzeit sogar nur Mozilla bzw. Netscape 6.1 einigermaßen richtig darstellen.

Weitere Entwicklungen im Internet liegen in der Weiterentwicklung von Suchmaschinen und der geeigneten Ausgabe von Suchergebnissen. So zeigt sich bei einer stark steigenden Zahl an Webseiten immer mehr die Notwendigkeit von neuen Verfahren um die Ergebnisse einer Suchmaschine einzugrenzen. Gleichzeitig muß die Darstellung der Ergebnisse intuitiv erfassbar bleiben.

Weitere Entwicklungen im Internet liegen in der Weiterentwicklung von Suchmaschinen und der geeigneten Ausgabe von Suchergebnissen. So zeigt sich bei einer stark steigenden Zahl an Webseiten immer mehr die Notwendigkeit von neuen Verfahren um die Ergebnisse einer Suchmaschine einzugrenzen. Gleichzeitig muß die Darstellung der Ergebnisse intuitiv erfassbar bleiben.

Hier weisen aktuelle Projekte und Forschungsergebnisse hauptsächlich auf 3 Ansatzpunkte:

- Bei der Suche wird nicht mehr nur eine Wortsuche ausgeführt, sondern auch eine inhaltliche Interpretation und Verknüpfung. So soll eine Suche nach „software + spiel“ ebenso Ergebnisse liefern, die diese beiden Begriffe nicht haben, aber inhaltlich treffend sind.

- Verteilte Suchmaschinen setzten sich immer mehr durch. Diese arbeiten nach dem Prinzip erst lokale Datenbestände zu durchsuchen und danach die Suchergebnisse anderer Suchmaschinen des Verbundes zurückzugeben.

- Grafische Suchmaschinen und Indices werden aufgrund ihrer intuitiven Bedienung und übersichtlichen Darstellung populärer und werden gleichzeitig immer ausgereifter. Ein Vertreter dieses Genres ist WebMap.

4. Internet-Dienstleister – Das Ende der „Kostenlos-Kultur?“

Nachdem der Markt der Internet-Dienstleiter sich immer mehr bereinigt und unrealistische Geschäftsideen, durch die gestiegene Erfahrung der Anwender und Geldgeber, immer leichter erkannt werden, setzten sich Anbieter mit einer stabilen Geschäftsgrundlage immer mehr durch. Dies bedeutet jedoch nicht zwangsläufig eine gestiegene Qualität bei den Dienstleistungen. Zwar propagieren Vertreter großer Unternehmen, wie die Telekom, das „Ende der Kostenlos-Kultur“, jedoch steht dem die Tatsache entgegen, daß das Internet nicht allein Firmen- und StartUp-Angeboten besteht, sondern vor allem aus einer Unzahl von privaten Seiten, die jeder für sich Informationen kostenlos bereitstellen. Die Frage, die sich Firmen stellen müssen, ist, ob die Inhalte, die sie zur kostenpflichtig Verfügung stellen wollen, auch wirklich von der Qualität her besser ist als das was kostenlos angeboten wird. Hier wird auch die OpenSource-Szene ein Wirkung haben. Gerade der OpenSource-Webserver Apache zeigt unwiderlegbar, daß kostenlose Angebote sowohl qualitativ sehr hochwertig sein können, als auch das Support-Firmen finanziell sehr gut davon profitieren können. Traditionelle Firmen, die kommerzielle Angebote im Web und/oder Internet anbieten wollen, werden daher in den nächsten Monaten verstärkt dazu übergehen, Kundenbindung zu betreiben. Und dies nicht nur als Einwahlprovider, wie im Falle der Telekom oder AOL, sondern auch in bezug auf die Benutzung der Webseiten: Immer mehr und bessere Angebote auf den jeweiligen Portalen sollen dafür sorgen, daß der Kunde möglichst wenig andere Seiten besucht und von der Qualität des „Heimatportals“ überzeugt ist.

Ist der Kunde erst mal von der hohen Qualität des Dienstleisters überzeugt (oder besser: überredet), wird er bei diesem auch kostenpflichtige Angebote annehmen, selbst wenn es dieselben oder bessere Informationen auf anderen, aber kostenlosen Angeboten gibt. Denn sobald der Kunde überzeugt vom Portal des Anbieters ist, wird er diesem auch eher glauben, daß die kostenpflichtige Angebote hochwertig sind, und somit alle anderen kostenlosen Angebote minderwertig sein müssen.

Entsprechend diesem Ziel wird die kommende Unternehmenswerbung ausgerichtet sein: Allein das beworbene Unternehmen ist im Besitz der einzigen hochwertigen und vollständigen Information; Alles andere, insbesondere OpenSource-Angebote, sei unzuverlässig, fehlerhaft, wenn nicht gar gefährlich oder kriminell.

5. Kulturraum Internet

Die Anzahl der Benutzer des Internets ist seit der Einführung vom WorldWideWeb im Jahre 1994 stark gestiegen und wächst weiter. Nach Angaben des Marktforschungsinstituts Forsa hat die Anzahl der deutschen Internetnutzer im Juni die 40-Prozent-Marke überschritten.

Für einen „Anfänger“ besteht das Internet meist nur aus dem WorldWideWeb und den Seiten des Einwahlproviders und Seiten von Presse und Fernsehen.

Mit der steigenden Erfahrung der Benutzer sind diese immer mehr dazu geneigt andere Webangebote und deren Dienste zu besuchen. Fast zwangsläufig kommt man mit Messenger-Diensten, Chats, Diskussionsforen und privaten Homepages in Kontakt. Und von diesen ist der Schritt zu weiteren Angeboten, wie IRC, Multi-User-Dungeons, Avatar-Chats etc. nicht fern. Ebenso wird bei vielen Benutzern der Wunsch nach einer eigenen Repräsentation im „Netz“ merkbar. Dies nicht nur aus privaten, sondern auch aus beruflichen Gründen: Immer mehr Firmen, insbesonders aus den Branchen IT, Werbung, Design und Entwicklung, wickeln ihre Jobsuche über das Internet ab und lassen sich auch über E-Mail kontakten. Die Präsentation eines Lebenslaufes oder andere Informationen im Netz ist für Firmen dieser Branchen teilweise zu einem Indiz für die fachliche Qualifikation des Bewerbers geworden (Vgl: http://www.jobs.de).

Bedingt durch die Benutzung dieser verschiedenen Möglichkeiten hat sich bereits eine Art „Kulturraum Internet“ gebildet, welcher aus der Gesamtheit der privaten Angebote, aber auch der virtuellen Treffpunkte von Surfern besteht. Passend hierzu sprechen neuere wissenschaftliche Analysen auch nicht mehr vom Szenario des „einsamen und depressiven Surfers“, der in einer anonymen, digitalen Suchtwelt gefangen ist, sondern stellten fest, daß das Internet als Kommunikationsmedium mehr Menschen als zuvor möglich zusammenführt und sich austauschen läßt und im Gegenteil der Förderung von neuen sozialen Bindungen dienlich sei (Vgl: Heise: „Internet macht depressiv – oder doch nicht?“).

Von Bedeutung ist die gestiegene Zahl der Nutzer auch für die Politik. Jede größere Partei hat inzwischen einen oder mehrere „Internet-Beauftragte“ ernannt; Das deren Aufgabe derzeit meist noch in der Weiterbildung der eigenen Parteipolitiker (zum Beispiel solcher, die einen „Sendezeitpunkt nach 23 Uhr für Internetseiten“ fordern) oder der interner Organisation liegt, gehört zu den „Kinderkrankheiten“ dieser neuen Positionen. Bedingt durch die „surfende Basis“ ist jedoch auf absehbarer Zeit damit zu rechnen, daß die Kompetenz der Politiker auf diesem Gebiet steigt. Auswirkung hat dies konkret darin, daß diese IT-Kompentenz in den anstehenden Entscheidungen auf EU-Ebene zum Patent- und Markenrecht wichtig ist, aber auch zu den Debatten über Urheberrecht und der notwendigen Neufassung des Telekommunikationsgesetzes bedeutend ist.

Fazit

Die Entwicklung des Internets in den nächsten Monaten läßt sich im Wesentlichen durch ein Wort beschreiben: „Konsolidierung“. Es ist innerhalb des nächsten halben Jahres nicht mit einer Sensation oder einer wie auch immer gearteten Umwälzung zu rechnen. Daran wird auch das sich in den Startlöchern befindliche Windows XP nichts ändern, selbst wenn der dazugehörige Medien- und Werberummel temporär eine andere Sprache sprechen wird.

Neue Dienste im Netz werden im Wesentlichen aus Weiterentwicklungen von vorhandenen bestehen. Firmen und Unternehmen, die durch die „StartUp-Krise“ arg gebeutelt wurden, werden diese Zeit nutzen um ihre Marktposition zu festigen und Altlasten, die zuvor durch falschen Enthusiasmus entstanden, beseitigen. Das dieser Vorgang Zeit kostet und nicht immer sehr Schmerzfrei abläuft, zeigt sich derzeit an den Kursständen im Neuen Markt.

Das Licht am Ende des Tunnels zu erwarten ist, zeigt jedoch eine aktuelle Studie von „manager magazin“ und Bain über den Stand der E-Business-Vorhaben der Top 100-Unternehmen in Deutschland: Zwei Drittel der Unternehmen sehen, trotz der Krise auf dem Neuen Markt, im Web eine Chance für Ihr Unternehmen (Vgl: http://www.manager-magazin.de/ebusiness/artikel/0,2828,145892,00.html).

Für die Benutzer wird sich technisch innerhalb der nächsten Monaten selbst kaum neues ergeben – es sei denn, man wechselt in dieser Zeit den Browser oder den Provider. Inhaltlich werden die Benutzer jedoch mit einer steigenden Zahl an SPAM-Mails zu rechnen haben (Vgl: Studie: Immer mehr Spam-Mails unterwegs) und -bedingt durch die anstehenden Entscheidungen in der EU- mit den Aufkommen von politischen und rechtlichen Diskussionen und Streitigkeiten über IT-Themen.